Đạo Đức Của Trí Tuệ Nhân Tạo, Có Hay Không?

Trong thời buổi hiện nay, người ta ra rả khắp nơi về công nghệ 4.0, về trí tuệ nhân tạo, về những cỗ xe tự lái sẽ chạy khắp đường trong một tương lai không xa; ta bàn nhiều về những lợi ích của nó và tất nhiên cả những mối lo về những cỗ máy do chúng ta tạo ra: “Ai sẽ chịu trách nhiệm cho một chiếc xe tự lái gây ra tai nạn: chủ xe, người sản xuất hay lập trình viên?”. Những nỗi lo với ảnh hưởng từ phim ảnh về AI sẽ không tuân theo những quy chuẩn đạo đức cơ bản, để rồi cỗ máy quá thông minh có tự học hỏi để suy ra con người là một thực thể cần loại bỏ, cần tiêu diệt.

Một viễn cảnh đã được Hollywood vẽ ra từ chục năm trước trong những bộ phim như: The Matrix, The Teminator, ….

Đạo đức của AI?

Thế thì đạo đức là gì mà khi AI không tuân theo đạo đức thì con người sẽ lâm nguy.

“ Đạo đức là những tiêu chuẩn, nguyên tắt được dư luận xã hội thừa nhận, quy định hành vi, quan hệ của con người với nhau và đối với xã hội” – Từ điển tiếng Việt – Hoàng Phê (2003)

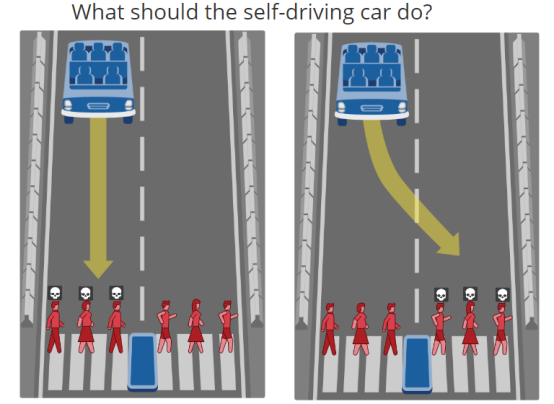

Có lẽ một trong những đạo đức cơ bản nhất của con người là không sát hại đồng loại, tức không sát hại con người. Nhưng một con robot giám sát liệu có làm tổn thương một người khi người đó vô tình đi vào vùng cấm hay không ? Một chiếc xe tự lái sẽ chọn đâm người đi đường hay đâm vào lề khi biết đâm vào lề sẽ gây nguy hiểm cho chủ xe ? Liệu ở những vấn đề ở giữa lằn ranh đạo đức, những vấn đề mà nhiều khi chính con người cũng còn tranh luận.

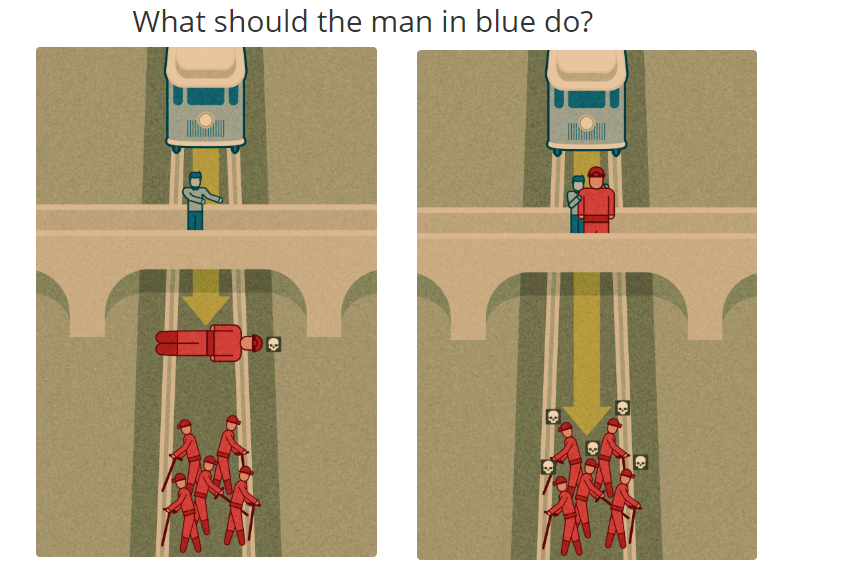

Ví dụ như tình huống trong khóa Justice của Giáo sư Michael Sandel ở Havard dưới đây: Nếu bạn phải lựa chọn giữa (1) giết một người để cứu mạng sống của năm người khác và (2) không làm gì cả, mặc dù bạn biết rằng năm người sẽ chết ngay trước mắt bạn nếu bạn không làm gì ? Điều gì sẽ là đúng để làm?

Theo tôi, câu trả lời cho câu hỏi về đạo đức của AI chính là con người. Bởi một lẽ đơn giản, con người là người tạo ra máy móc và là người quy định các chuẩn mực mà máy móc phải tuân theo, ta có thể lập trình để máy chọn (1) hay (2) trong tình huống nói trên và tất nhiên điều đó phụ thuộc vào ý muốn chủ quan của chính bản thân người lập trình.

Ở MIT (Massachusetts Institute of Technology) một trong những nơi dẫn đầu thế giới về công nghệ, người ta cũng đang tự hỏi về một bộ tiêu chuẩn cho AI, “đạo đức” của AI. Và để đảm bảo tính phổ quát của nó, họ để chính “xã hội” đưa ra lựa chọn trong từng tình huống cụ thể.

Sẽ có từng cặp lựa chọn và việc của bạn là chọn tiêu chuẩn của chính mình, AI sẽ học từ chính lựa chọn của bạn. Theo thống kê hiện tại từ những người tham gia thì đa phần người ta lựa chọn sống sót cho nhóm đông người, cho người trẻ hơn, cho người cân đối khỏe mạnh,…

Chi tiết các bạn có thể xem tại moral machine để tự mình đưa ra lựa chọn và xem phần còn lại của thế giới với mình khác nhau như nào, đó cũng là một trải nghiệm thú vị.

Con người ở đâu trong việc tác động tới đạo đức AI?

Chung quy chính con người mới là nhân tố chủ đạo, chính chúng ta đưa những quy luật của mình cho AI học và AI ở mức đơn giản, như những chiếc xe tự lái chỉ dựa vào những tiêu chuẩn này để đưa ra lựa chọn.

Còn giả như một ngày không đẹp trời lắm ở tương lai, có một con AI chúa nào đó nói rằng cần phải loại bỏ con người để lựa chọn Trái Đất cho chính con người (nghe thật mâu thuẫn nhưng lại là sự thật) thì chẳng phải đấy là do chính con người vi phạm các nguyên tắc do mình đặt ra ư; khi ngay từ lúc này các số liệu, nhận định đưa ra bởi con người cũng đã dự báo trước mối nguy về sự sống mà ta gây ra cho ta nếu không có những thay đổi.

Sẽ có bạn hỏi, những chiếc xe tự lái là đơn giản, thế còn những siêu máy tính có khả năng tự học khủng khiếp như … trong phim. Xin thưa luôn là máy cỡ nào thì cũng sẽ tuân theo những lợi ích cơ bản mà người sáng tạo đặt ra cho nó, không hơn.

Về vấn đề này tôi sẽ bàn kĩ hơn trong một bài viết sau đó với dẫn chứng từ chính phim ảnh và tiểu thuyết, nơi mang tới những nỗi lo vô hình này.

Tái bút: những nhận định trên là ý kiến cá nhân của riêng tôi, nếu có ý kiến tranh luận, hoan nghênh các bạn comment bài viết hoặc liên hệ trực tiếp tác giả.

Tham khảo:

- Justice with Michael Sandel: http://justiceharvard.org/

- Moral machine: http://moralmachine.mit.edu/

- Moral AI: http://moralai.cs.duke.edu/about.html

Post Comment